electronica-news.es

29

'21

Written on Modified on

Mouser News

La integración en la periferia

La computación en la nube ha aportado un gran número de ventajas, como un entorno de trabajo más flexible, con herramientas potentes y productivas para el teletrabajo —algo esencial durante la pandemia—, y también ha democratizado el acceso a recursos importantes y de última generación, como la inteligencia artificial (IA) o las aplicaciones de datos masivos o de «Big Data».

La nube es el centro del Internet de las cosas (IdC), lo que significa que gestiona miles de millones de sus terminales, como sensores ambientales, accionadores industriales, vehículos autónomos, etc. Sin duda, la nube es un factor fundamental para que empresas y particulares puedan disfrutar de las ventajas de un mundo más inteligente.

Sin embargo, también tiene sus inconvenientes. Una conexión constante a Internet supone un consumo importante de energía y puede ser tecnológicamente complicado o caro, en el caso de dispositivos pequeños. Si todos los datos, por insignificantes que sean, deben pasar por la nube, se pueden producir atascos en el tráfico de datos de máquina a máquina. Además, la nube introduce latencias que podrían afectar al suministro de servicios y evitar que los dispositivos del IdC actúen de forma determinista en tiempo real. A todo esto, hay que añadir que la transmisión de datos en redes y con aplicaciones en la nube está acompañada de problemas de seguridad y privacidad.

Rastreamiento del esfuerzo de procesamiento

Es cada vez más frecuente que la potencia de computación necesaria para procesar datos y tomar decisiones basándose en los resultados pase de estar en la nube a formar parte de la periferia de la red. Desde el punto de vista del portador o de la informática corporativa, la computación periférica consta de dispositivos de puerta de enlace en la periferia de una red principal. A su vez, esto se puede dividir en infraestructuras de la periferia interna, que suelen alojar servicios genéricos, y la periferia externa, donde están las aplicaciones más específicas, en un punto más cercano al usuario final.

Al disponer de más potencia de computación, la periferia está pasando a ser cada vez más inteligente. Pero, ¿por qué detenernos aquí? Si seguimos moviendo la computación hacia las capas externas e incluimos los terminales del IdC (como sensores, accionadores, acumuladores de datos y puertas de enlace), estaremos creando la periferia integrada. En este campo, están apareciendo nuevas soluciones para superar las limitaciones a las que siempre se han enfrentado los diseñadores de sistemas integrados, por ejemplo, el consumo de potencia, el rendimiento de computación, el espacio ocupado por la memoria y las dimensiones físicas.

¿Qué aporta el procesamiento periférico?

La periferia integrada aprovecha los avances de las diferentes generaciones de procesadores (capaces de gestionar tareas muy complejas con un rendimiento más rápido y un menor consumo de potencia) y se convertirá en uno de los pilares del procesamiento del IdC.

Algunas áreas en las que el procesamiento periférico puede aportar un gran rendimiento son la Industria 4.0 o los vehículos autónomos, donde la baja latencia y la independencia de la red son esenciales. Algunos ejemplos son la visión robótica (imagen 1) y la conducción de vehículos, que pueden mejorar notablemente con la inclusión de la inferencia por aprendizaje automático en sistemas integrados.

El aprendizaje automático puede superar el rendimiento de las aplicaciones convencionales de visión artificial y permitir nuevas funciones. Por ejemplo, un vehículo autónomo (AGV) puede identificar y clasificar los objetos que se encuentra en el camino y no solo detectarlos. Esto es un cambio muy importante, ya que las fábricas son entornos cada vez más concurridos en los que las personas y los robots móviles o estáticos comparten un espacio limitado.

Del mismo modo, el aprendizaje automático puede mejorar la eficacia del reconocimiento de patrones en sistemas industriales para la monitorización del acondicionamiento, a fin de aumentar la precisión de los diagnósticos. El aprendizaje automático también puede aportar varias ventajas a otras aplicaciones, como la agricultura inteligente, donde el aprendizaje en el reconocimiento de imágenes se puede aplicar para identificar enfermedades en los cultivos de forma autónoma y sin conexión a Internet.

El aprendizaje automático con TinyML

Recientemente se ha desarrollado el concepto del aprendizaje automático en dispositivos pequeños (Tiny Machine Learning o TinyML) con el objetivo de implantar estas funciones en dispositivos integrados. El TinyML hace referencia a entornos de aprendizaje automático diseñados para sistemas integrados con recursos limitados. Los desarrolladores necesitan herramientas para crear modelos de aprendizaje automático y entrenarlos; a continuación, deben optimizarlos para poder usarlos en el dispositivo periférico, como un microcontrolador, un procesador pequeño o un FPGA.

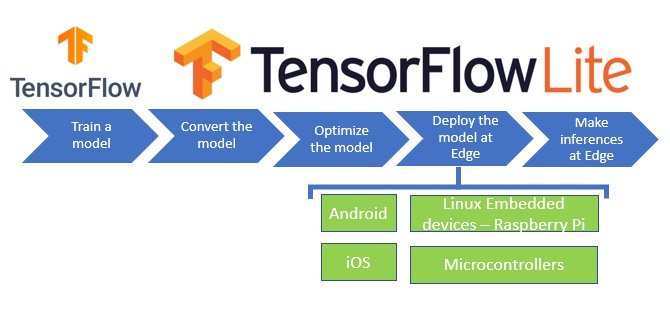

Los principios del TinyML se han incorporado en entornos de aprendizaje automático pensados para la periferia, como TensorFlow Lite (imagen 2). Se trata de un entorno muy popular, con herramientas como un convertidor que optimiza los modelos estándar TensorFlow para que se puedan ejecutar en un destino (como un dispositivo Linux integrado) y un intérprete para ejecutar el modelo optimizado.

Tensorflow Lite optimiza los modelos de aprendizaje automático para que se puedan implementar en sistemas integrados.

Además, TensorFlow Lite for Microcontrollers se ha diseñado específicamente para ejecutar el aprendizaje automático en dispositivos con una memoria extremadamente limitada. La ejecución principal solo ocupa unos cuantos kilobytes de memoria y se ha probado en muchos microcontroladores con núcleos Arm® Cortex®-M. Las herramientas de TensorFlow Lite nos ofrecen diferentes maneras de reducir el tamaño de los modelos TensorFlow para utilizarlos en un dispositivo integrado o un microcontrolador.

Soluciones para la inferencia periférica

Los proveedores más importantes de microcontroladores ya han lanzado ecosistemas y flujos de procesos para la implantación del aprendizaje automático y la inferencia por IA. Ya es posible disponer de microcontroladores integrados preparados para la implantación de redes neuronales a fin de ejecutar algoritmos de aprendizaje automático.

Están apareciendo nuevas generaciones de microcontroladores en los que la inferencia con aprendizaje automático es una parte fundamental del diseño. Un ejemplo de esto son los procesadores TI Sitara, como el AM5729, que contiene dos núcleos Arm Cortex-A15, un núcleo integrado Cortex-M4 y cuatro motores de visión integrada (EVE) para la compatibilidad con redes de aprendizaje profundo, algo que garantiza una inferencia de alto rendimiento. El entorno de software TI Deep Learning (TIDL) y la interfaz TIDL ayudan a los desarrolladores a crear e implantar redes neuronales en procesadores integrados, así como a entrenar a estas redes.

Una de las herramientas del kit de STMicroelectronics para redes neuronales es la función de conversión STM32Cube.AI, que permite convertir redes neuronales entrenadas que se hayan creado con entornos populares. Esta herramienta genera de forma automática bibliotecas optimizadas para microcontroladores STM32 Arm Cortex-M de ST. El ecosistema de IA también contiene paquetes de funciones de software con las bibliotecas de conectividad (middleware) y los «drivers» de nivel bajo necesarios para implantar la red neuronal entrenada. También hay aplicaciones de muestra para la clasificación de escenas de audio y la detección de actividad humana, a fin de que los usuarios puedan aprender rápidamente a utilizar la IA integrada. El kit contiene además una aplicación móvil específica y SensorTile, el hardware de referencia de ST, para la ejecución de las inferencias o la recopilación de datos. SensorTile es una placa completa con sensores de contexto y ambientales preintegrados como un módulo «plug and play».

Microchip ofrece compatibilidad para el aprendizaje automático en sus microprocesadores, FPGA y microcontroladores de 32 bits, como la serie SAM D21. Este proveedor dispone de herramientas con las que los desarrolladores pueden usar entornos de aprendizaje automático populares, como TensorFlow, Keras y Caff y entornos TinyML, como TensorFlow Lite. El uso de las herramientas MPLAB® con microcontroladores o microprocesadores permite a los desarrolladores aprovechar las prestaciones de herramientas como ML Plugin o MPLAB Data Visualizer para la captura de datos, entrenando así las redes neuronales con las herramientas de los socios de Microchip; por ejemplo, Cartesiam Nano Edge AI Studio —que busca modelos IA, analiza datos de sensores y genera bibliotecas automáticamente— o Edge Impulse Studio, junto con la biblioteca Edge Impulse Inferencing SDK C++, que utiliza TensorFlow Lite for Microcontrollers. Los usuarios pueden implementar sus proyectos en el MCU que deseen con el IDE Microchip MPLAB X.

La plataforma de inteligencia artificial integrada (e-AI) de Renesas abarca diferentes conceptos para la implantación de la IA en terminales. Los microprocesadores Renesas RZ/A2M disponen de la tecnología DRP (procesadores reconfigurables dinámicamente), que combina el rendimiento de un acelerador de hardware con la flexibilidad de una CPU a fin de lograr una visión artificial de alta velocidad y bajo consumo. La plataforma también incluye algunas herramientas, como el traductor e-AI, que convierte e importa el procesamiento de la inferencia de los modelos de redes neuronales entrenados en archivos de código fuente que se pueden emplear en un proyecto e² studio IDE C/C++. Las redes neuronales se pueden entrenar con un entorno de aprendizaje profundo y código abierto como TensorFlow.

Además, tanto los creadores como los jóvenes ingenieros y los profesionales pueden obtener experiencia en la fabricación de dispositivos inteligentes con los kits de IA de Google AIY y la plataforma de IA local Google Coral. Los kits de AIY contienen una cámara inteligente —con una placa Raspberry Pi y una cámara—, un accesorio llamado Vision Bonnet, los cables y pulsadores necesarios y una carcasa de cartón, para que los usuarios puedan aprender rápidamente los conceptos del reconocimiento de imágenes. También hay un kit inteligente de audio para estudiar el reconocimiento de voz.

Google Coral ofrece diferentes opciones de hardware, como una placa y una miniplaca de desarrollo y un acelerador USB con coprocesador, para que los usuarios puedan «conectar» la IA a otros productos. El conjunto de herramientas es compatible con TensorFlow Lite y con todas las placas que tengan la Edge TPU de Google, una unidad de procesamiento tensorial relacionada con Google Cloud TPU que se ha diseñado específicamente para tamaños reducidos y un bajo consumo de potencia.

Conclusión: El futuro de la periferia es la inteligencia integrada

Si aumentamos la potencia computacional de los dispositivos periféricos, obtendremos un IdC más fiable, de alto rendimiento y más preparado para respetar la privacidad. Los equipos en distintas ubicaciones, como puertas de enlace de red y acumuladores o terminales del IdC, se pueden considerar dispositivos periféricos. La inteligencia artificial es cada vez más necesaria para satisfacer la demanda de rendimiento y eficacia; por ejemplo, en las soluciones de aprendizaje automático para la implementación en microcontroladores. Estas soluciones incluyen entornos TinyML de código abierto y arquitecturas de microcontrolador aceleradas y optimizadas de los fabricantes más importantes. Existen diferentes herramientas, plataformas y kits «plug and play» disponibles para que los desarrolladores puedan explorar las posibilidades, tanto si son principiantes como profesionales con experiencia.

www.mouser.com